栏目分类

发布日期:2024-12-24 05:20 点击次数:59

克雷西 发自 凹非寺

量子位 | 公众号 QbitAI

斯坦福吴佳俊团队,给机器东谈主遐想了一套拼装宜家产物的视频教程!

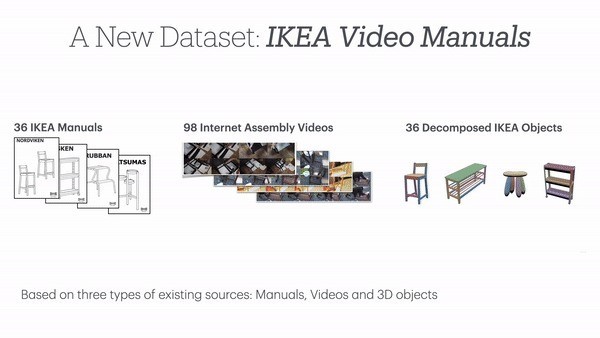

具体来说,团队建议了用于机器东谈主的大型多模态数据集IKEA Video Manuals,已入选NeurIPS。

数据集涵盖了6大类IKEA产物,每种产物都包含完好的3D模子、拼装阐明书和骨子拼装视频。

而且分离细致,拆解出的安装子法度多达1000多个。

作家先容,该数据集初度终结了拼装提醒在真确场景中的4D对皆,为盘考这一复杂问题提供了紧迫基准。

着名科技博主、前微软政策盘考者Robert Scoble说,有了这个数据集,机器东谈主将不错学会我方拼装产物。

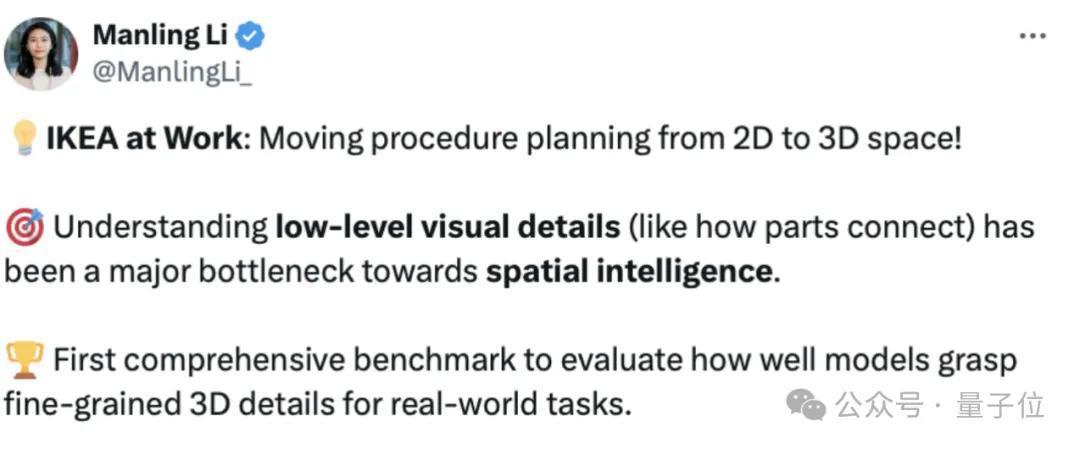

团队成员、斯坦福拜访学者李曼玲(Manling Li)默示,这是空间智能鸿沟的一项紧迫职责:

这项职责将拼装贪图从2D激动到3D空间,通过领路底层视觉细节,贬责了空间智能盘及第的一个主要瓶颈。

1120个子法度胪陈拼装进程

IKEA Video Manuals数据麇集,涵盖了6大类36种IKEA产物,简约单的凳子到复杂的柜子,呈现了不同难度的拼装任务。

每一款产物,都包括以下三种模态:

安装阐明书,提供了任务的全体理解和环节法度;真确拼装视频,展示了肃穆的拼装进程;3D模子,界说了部件之间的精准空间相干。何况这三种模态并非简陋地堆砌在一齐,作家通过对视频和操作法度的拆解,将三种模态进行了细致的对皆。

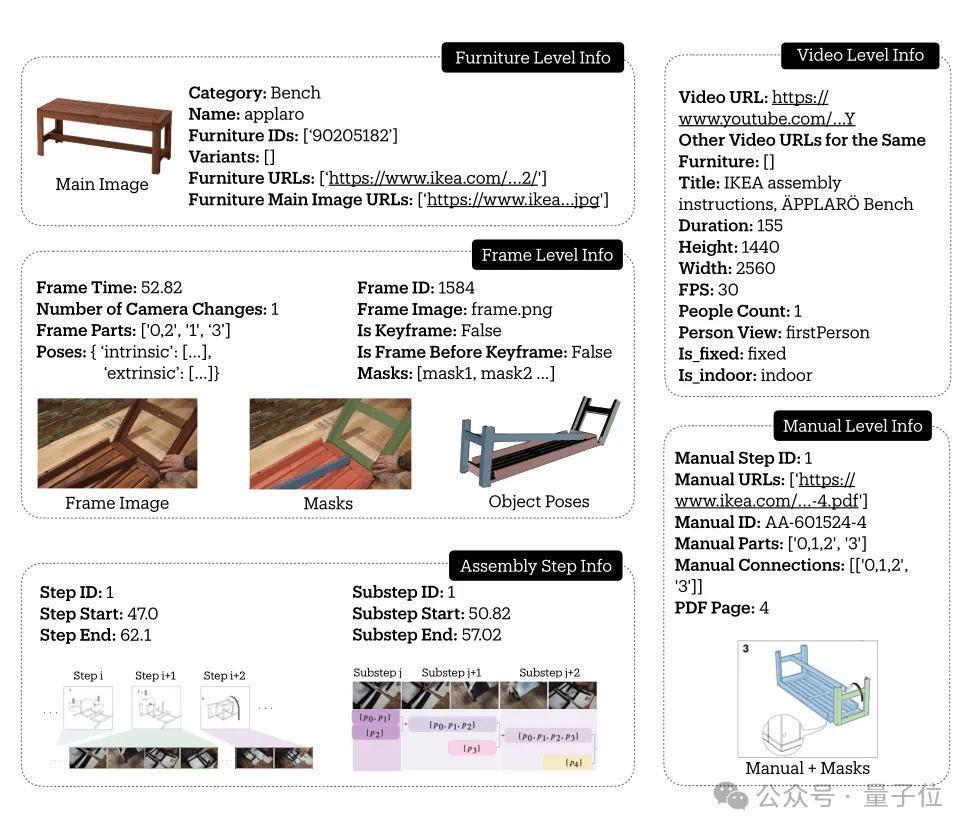

举个例子,在这么一条对于长凳的数据当中,包含了其基本大概、视频信息、环节帧信息,以及安装法度。

从下图中不错看出,安装法度当中有主要法度和子法度的分离,还标注了对应的视频位置。

整个数据麇集,共包含了137个手册法度,把柄安装视频被细分为了1120个具体子法度,捕捉了完好的拼装进程。

何况通过6D Pose追踪,每个部件的空间轨迹都被精准纪录,最终在视频帧、产物拼装阐明书和3D模子之间建设了密集的对应相干。

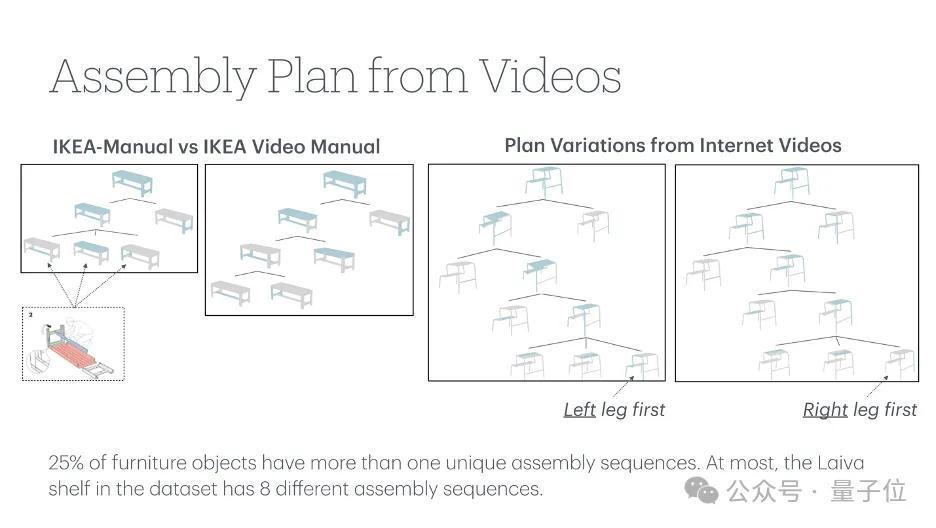

时空信息细致标注IKEA Video Manuals数据集是在IKEA-Manual和IKEA Assembly in the Wild(IAW)两个数据集的基础上建设的。

其中,IKEA-Manual数据集提供了模子偏执对应阐明书,IAW则包含了无数用户拼装宜家产物的视频片断。

这些视频来自90多个不同的环境,包括室表里场景、不同光照条款,真确反馈了产物拼装的各样性。

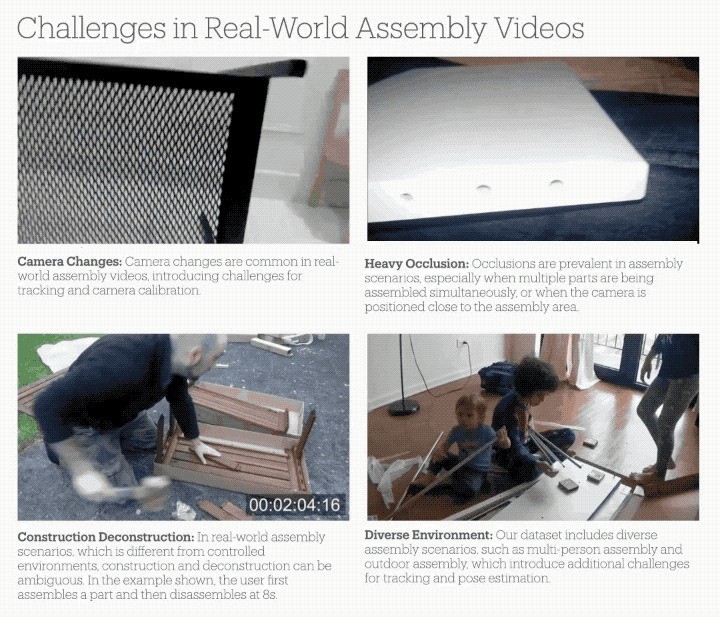

与在实际室环境下网络的数据比拟,这些真确视频带来了更丰富的挑战:

部件时常被手或其他物体隐蔽;相似部件识别(如四条一模一样的桌子腿);录像机频繁转移、变焦,带来参数测度的贫穷;室表里场景、不同光照条款下的各样性。

为了得到高质料的标注,搪塞真确视频带来的挑战,盘考团队建设了一套可靠的标注系统:

识别并标注相机参数变化的环节帧,确保片断内的一致性;纠合2D-3D对应点和RANSAC算法进行相机参数测度;通过多视角考据和时序不绝保证标注质料。

领先,盘考者们领先界说了一套档次化的安装进程描画框架,将整个安装进程分为法度、子法度和视频帧等多个层级。

作家领先从IAW数据麇集索要每个手动法度的视频片断,并将每个视频片断理解为更小的阻隔(子法度)。

对于每个子法度,作家以1FPS的速率采样视频帧,并在每个子法度的第一帧中标注坐褥物部件。

为了在整个拼装视频中对产物部件进行追踪,作家还在采样帧中为3D部件注视了2D图像分割掩码。

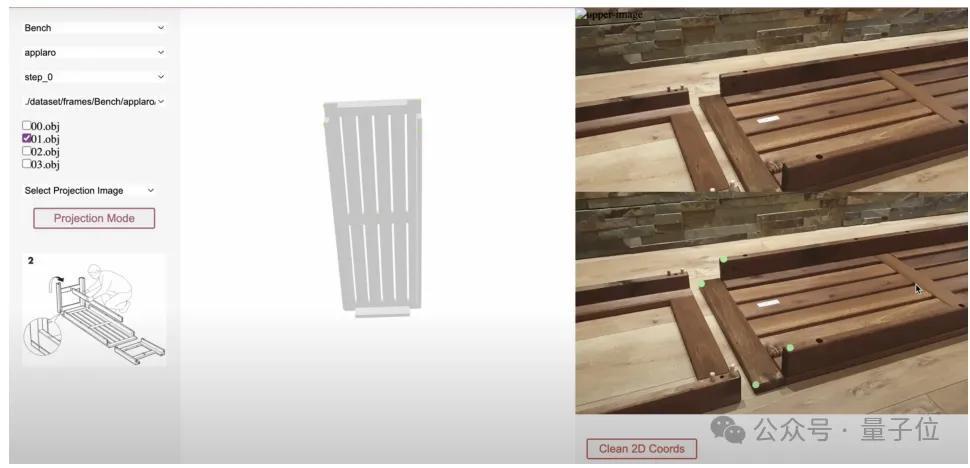

为了促进注视进程,盘考团队开导了一个显现接济2D和3D信息的Web界面,同期该界面还可基于Segment Anything Model(SAM)模子进行交互式掩码注视。

标注进程中,标注东谈主员会在3D模子上选中零件,然后在2D视频帧上指挥其苟简位置,并将其输入到SAM模子中以及时生成2D分割掩码。

为了贬责SAM在索要具有相似纹理的部分之间或低光区域的鸿沟方面的固有局限,作家还允许标注东谈主员使用画笔和橡皮擦器具进行手动调遣。

此外,作家还要测度视频中的相机参数,为此盘考者们领先东谈主工标识出视频帧中可能出现相机通顺(如焦距变化、切换视角等)的位置,然后标注出视频帧和3D模子之间的2D-3D对应环节点。

终末,纠合这两类标注信息,盘考者们使用PnP (Perspective-n-Point)算法测度出每段视频的相机内参数,得到相机参数的入手测度后,运用交互式器具来细化每个视频帧中零件的6D姿态。

空间模子材干评估基于IKEA Video Manuals数据集,团队遐想了多个中枢任务来评估刻下AI系统在领路和扩充产物拼装,以及空间推理(spatial reasoning)方面的材干。

领先是基于3D模子的分割(Segmentation)与姿态测度 (Pose Estimation)。

此类任务输入3D模子和视频帧,要求AI准确分割出特定部件区域,并测度其在视频中的6解放度姿态。

△上:基于3D模子的分割,下:基于3D模子的姿态测度

实际测试了最新的分割模子(CNOS, SAM-6D)和姿态测度模子(MegaPose)。

分析发现,它们在以下场景进展欠安:

隐蔽问题:手部隐蔽、近距离拍摄导致部分可见、隐蔽引起的深度测度罅隙;特征缺失:缺少纹理的部件难以分割、对称部件的标的难以判断;荒谬拍摄角度(如俯瞰)导致的法度误判。

△上:隐蔽问题,左下:特征缺失,右下:荒谬角度

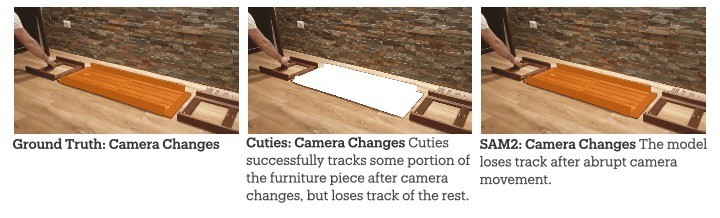

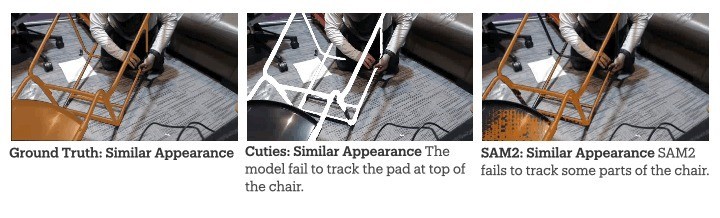

第二类任务是视频观点分割,作家对比测试了两个最新的视频追踪模子SAM2和Cutie。

成果显现,在真确拼装场景中,这些模子相同濒临着三大挑战。

一是相机的通顺,可能导致观点丢失。

二是难以区分外不雅相似的部件(如多个相通的桌腿)。

终末,保抓永劫分追踪的准确度也存在一定难度。

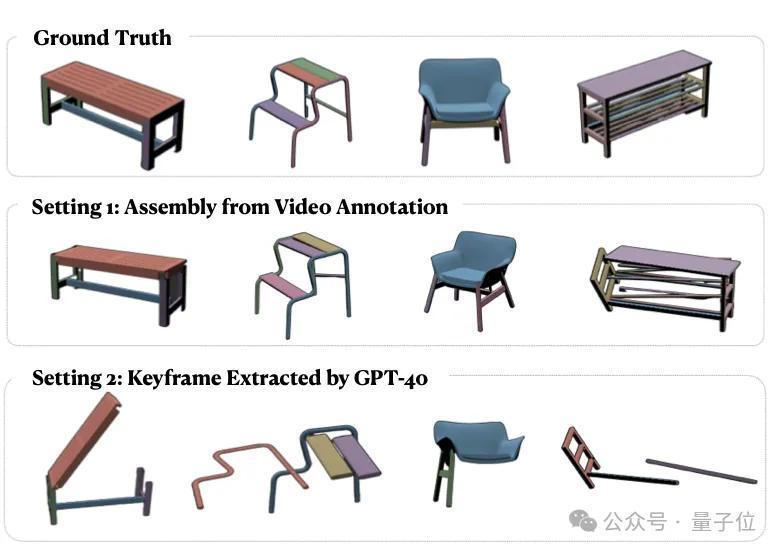

第三类任务,是基于视频的方法拼装。

团队建议了一个调动的拼装系统,包含环节帧检测、部件识别、姿态测度和迭代拼装四个法度。

实际罗致两种建设:

使用GPT-4V自动检测环节帧:成果不睬思,Chamfer Distance达0.55,且1/3的测试视频未能完成拼装;使用东谈主工标注的环节帧:由于姿态测度模子的局限性,最终Chamfer Distance仍达0.33。

这些实际成果揭示了刻下AI模子的两个环节局限:

视频领路材干不及:刻下的视频模子对时序信息的分析仍然较弱,频频停留在单帧图像分析的层面;空间推理受限:在真确场景的复杂条款下(如光照变化、视角改变、部件隐蔽等),现存模子的空间推理材干仍显不及。作家简介本名目第一作家,是斯坦福大学运筹帷幄机科学硕士生刘雨浓(Yunong Liu)现在在斯坦福SVL实际室(Vision and Learning Lab),由吴佳俊进修率领。

她本科毕业于爱丁堡大学电子与运筹帷幄机科学专科(荣誉学位),曾在德克萨斯大学奥斯汀分校从事盘考实习。

斯坦福大学助理进修、清华姚班学友吴佳俊,是本名观点率领进修。

另据论文信息显现,斯坦福大学博士后盘考员刘蔚宇(Weiyu Liu),与吴佳俊具有同等孝敬。

此外,Salesforce AI Research盘考主任Juan Carlos Niebles,西北大学运筹帷幄机科学系助理进修、斯坦福拜访学者李曼玲(Manling Li)等东谈主亦参与了此名目。

其他作家情况如下:

名目主页:

https://yunongliu1.github.io/ikea-video-manual/论文地址:https://arxiv.org/abs/2411.11409— 完 —

量子位 QbitAI · 头条号签约

存眷咱们,第一时分获知前沿科技动态